Análisis de logs para mejorar nuestro SEO

Cuando nos enfrentamos a proyectos con un elevado número de URL, o que estamos teniendo problemas de indexación, el análisis de logs resulta fundamental para entender el comportamiento de los bots de búsqueda a la hora de rastrear nuestro site.

¿Qué es un fichero de logs?

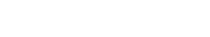

Antes de abordar cómo hacer en análisis es imprescindible tener unas nociones básicas de qué es un fichero de logs. Explicándolo de forma sencilla, no es más que un fichero de texto plano donde queda registrada toda la actividad de un site de forma cronológica. De forma que cada línea del archivo guarda una petición realizada al servidor.

Qué datos son los que nos interesan

No todos los datos que tenemos en los logs son imprescindibles de cara a un análisis enfocado al SEO. De todos los que podemos obtener estos son los que nos resultarán más prácticos:

- Fecha y hora de la petición

- IP desde la que se realiza la petición

- Estado de respuesta

- Tamaño de la respuesta

- Tiempo de entrega

- Subdominio de referencia

- Agente de usuario

- Subdominio al que se realiza la petición

- URL solicitada

Cada servidor muestras los logs con un formato determinado. Aquí podemos observar los formatos típicos de Apache y Nginx.

Ejemplo de configuración de logs en servidor Apache:

"%h %l %u %t \"%r\" %>s %b \"%{Referer}i\" \"%{User-agent}i\""

Ejemplo de configuración de logs en servidor Nginx

log_format combined_extra '$remote_addr - $remote_user [$time_local] ' '"$request" $status $body_bytes_sent ' '"$http_referer" "$http_user_agent" ' '$upstream_addr $request_time $upstream_response_time';

La herramienta de análisis de logs que empleemos debe ser capaz de interpretar estos formatos y obtener los datos que necesitemos.

Tipos de bots

De todas las líneas del fichero de logs del servidor nos interesan saber las que proceden de bots de búsqueda: Google, Bing, … por lo que debemos establecer filtros sobre el User-Agent.

Los bots de búsqueda más comunes son:

| Rastreadores |

Cadena de User-Agent completa |

|

Googlebot Desktop |

|

|

Googlebot Smartphone |

Mozilla/5.0 (Linux; Android 6.0.1; Nexus 5X Build/MMB29P) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/W.X.Y.Z Mobile Safari/537.36 (compatible; Googlebot/2.1; +http://www.google.com/bot.html) |

|

Googlebot-Image |

Googlebot-Image/1.0 |

|

Googlebot-Video |

Googlebot-Video/1.0 |

|

Googlebot-News |

Googlebot-News |

|

Bingbot Desktop |

Mozilla/5.0 (compatible; bingbot/2.0; +http://www.bing.com/bingbot.htm) |

|

Bingbot Mobile |

Mozilla/5.0 (iPhone; CPU iPhone OS 7_0 like Mac OS X) AppleWebKit/537.51.1 (KHTML, like Gecko) Version/7.0 Mobile/11A465 Safari/9537.53 (compatible; bingbot/2.0; +http://www.bing.com/bingbot.htm) |

En el siguiente enlace se pueden ver todos los User-Agent que utiliza Google.

Pero con esto no es suficiente, ya que es muy sencillo modificar el User-Agent ya sea desde nuestro navegador o desde herramientas de rastreo como Screaming Frog. Para asegurarnos de filtrar únicamente los registros de bots de búsqueda reales, debemos hacer una búsqueda de DNS invertida, de forma que se verifique que el nombre de dominio de la IP sea de un dominio asociado a un bot como pueden ser: googlebot.com o google.com (Googlebot), search.msn.com (Bingbot).

Si queremos evitar este paso, buscando en Google, podemos encontrar listados de IP válidas de los distintos bots de búsqueda.

¿Cuándo debemos hacer un análisis de logs?

Aunque haya ocasiones en las que analizar los logs de nuestros proyectos no sea una tarea prioritaria, en muchos otros casos sí debe serlo y además es algo que debemos abordar de forma recurrente. Estos son los casos más comunes

Sites muy grandes

Cuando trabajamos con sites con un elevado número de URL (más de 1 millón) es muy recomendable analizar los logs para detectar posibles problemas en el rastreo (errores 40X, 50X, redirecciones…) que nos impidan aprovechar al máxmo el crawl budget y esto dificulte que se pueda rastrear y, por tanto, indexar todas las URL que deseamos.

Problemas de indexación

Independientemente del tamaño del site, si estamos teniendo problemas para que nuestro site se indexe, es muy recomendable estudiar los logs para conocer las URL a las que está accediendo los bots. De este modo podremos saber si realmente el bot está pasando por las URL que queremos que sean indexadas o no. Si está pasando, las URL son indexables (devuelven código 200, no tienen un noindex y no están canonicalizadas) y no se está indexando es muy probable que tengamos problemas de thin content.

Cambios en la arquitectura del site

En muchas ocasiones, en nuestra estrategia para mejorar el posicionamiento orgánico de una web, se incluye una optimización de la arquitectura del site, en estos casos es muy recomendable asegurarnos de que los bots de búsqueda están rastreando las URL que se han visto afectadas.

Qué insights interesantes podemos obtener al analizar logs

Gracias al estudio de los logs, podemos sacar conclusiones interesantes con respecto a los siguientes datos

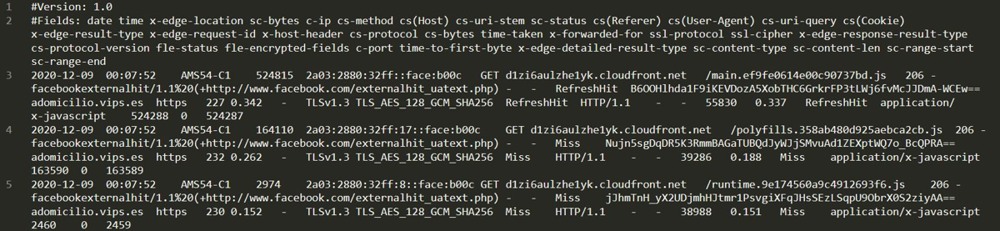

Frecuencia de rastreo

Estudiando el número de peticiones realizadas (hits) diarias realizadas por un bot de búsqueda, sabemos la frecuencia con la que nos está rastreando. Este es un dato muy interesante ya que, a nivel global, a mayor frecuencia de rastreo podemos considerar el interés de los bots de búsqueda en nuestro site. Este dato también se puede aplicar localmente, sobre URL o paths. Si el bot rastrea estos con frecuencia, demuestra que son URL consideradas relevantes.

Además, si hacemos optimizaciones en alguna URL, debemos prestar atención a los rastreos posteriores del bot, para asegurarnos de que se indexen los cambios realizados.

Este dato, además de con herramientas de análisis de logs, lo podemos obtener en Search Console

Tiempos de rastreo

Es importante conocer el tiempo que los bots dedican a rastrear nuestro site, ya que como sabemos, existe un presupuesto de rastreo (crawl budget) por parte de los robots de búsqueda, por lo que debemos conseguir que nuestro site sea rastreado de la forma más eficiente posible, optimizando nuestra arquitectura, pero también que los tiempos de respuesta sean lo más bajo posibles. Por ello identificar aquellas URL que se demoren demasiado en responder y realizar mejoras WPO resulta crucial.

Google Search Console nos ofrece una gráfica en la que podemos ver en los últimos 3 meses el tiempo medio de respuesta, pudiendo detectar días en los que este tiempo sufrió picos y como esto puede afectar al número total de solicitudes de rastreo.

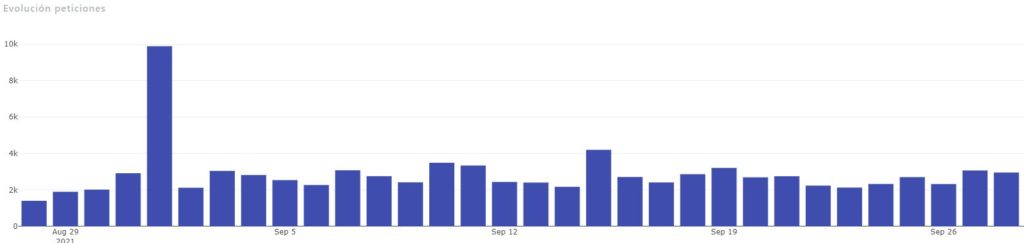

Peticiones con error 40X

Del mismo modo, identificar las URL que están devolviendo algún tipo de error 40X es fundamental, ya que un exceso de este tipo de errores puede tener un impacto negativo en nuestro posicionamiento. Para resolverlo, lo ideal es corregir el enlace que produce el error, de este modo optimizaremos el crawl budget mencionado anteriormente. Adicionalmente, podemos crear una redirección 301 a la URL correcta.

Google Search Console nos ofrece este informe, limitado a los tres últimos meses y a 1000 resultados.

Con una herramienta de análisis de logs como TransferLogs, desarrollada por Flat 101, podemos establecer los periodos que decidamos y estudiar la evolución de estos errores. Además, podremos identificar todas las URL que han generado este error

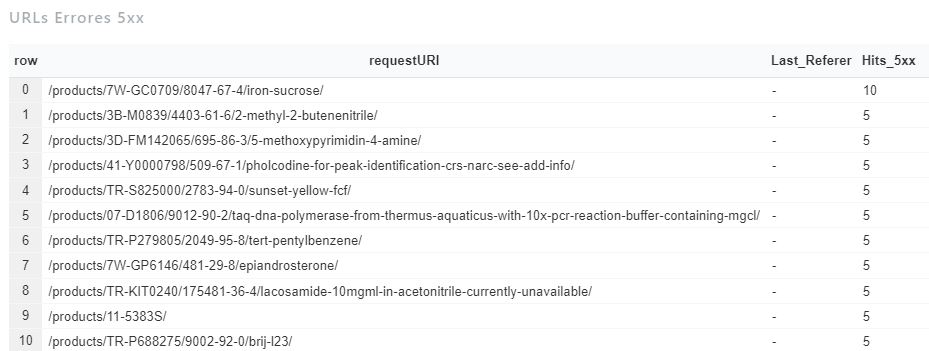

Peticiones con error 50X

Los errores de servidor se producen cuando se produce algún fallo en el servidor al procesar una solicitud. Estos errores, aunque no guarden relación con nuestra arquitectura y enlazado interno pueden provocar serios problemas en la indexación de nuestro site si no los detectamos y no los resolvemos, A veces son fallos puntuales, pero también pueden deberse a un problema grave en el servidor que debemos resolver.

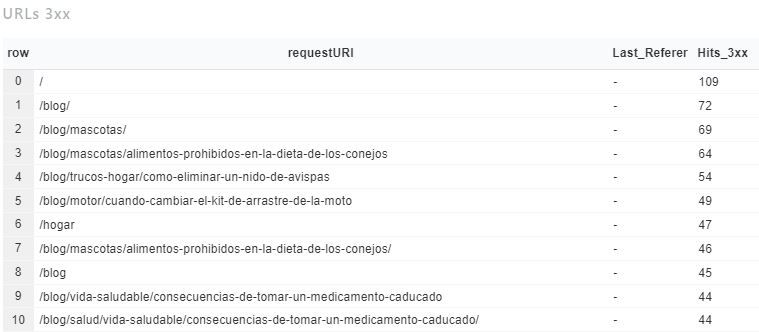

Peticiones con redirecciones

Evitar las redirecciones es muy importante, sobre todo en sites con un gran volumen de URL rastreables. Por ello identificar aquellas URL que generan redirecciones y corregirlas para que apunten a la URL final de la redirección es vital para optimizar el presupuesto de rastreo.

Este es otro dato que nos ofrece Search Console, pero de nuevo, limitado a tres meses y 1000 resultados.

Con Transferlogs podemos conseguir identificar las URL y las veces que han sufrido redirecciones en un periodo determinado.

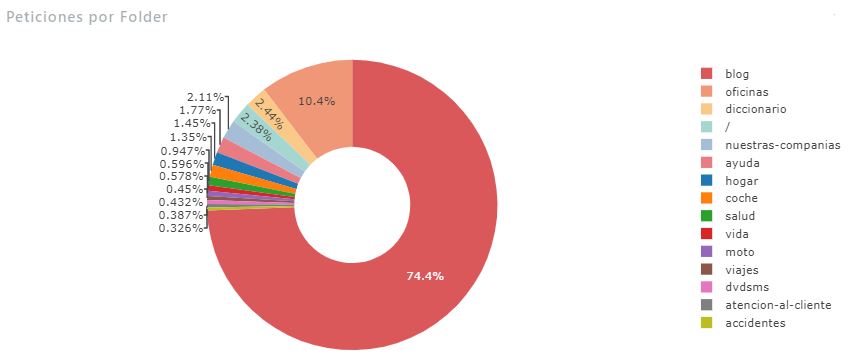

Peticiones por carpeta

Estudiando el número de peticiones que recibe una carpeta por parte de los bots nos hace saber cuán importante son las URL de dicha carpeta para el buscador. Este es un dato que debemos contextualizar, porque a mayor número de URL, lo lógico es que tenga más peticiones. Por ello, es un dato relevante para detectar posibles problemas si, por ejemplo, vemos que un directorio con un gran número de URL que queremos indexar, tiene pocas peticiones.

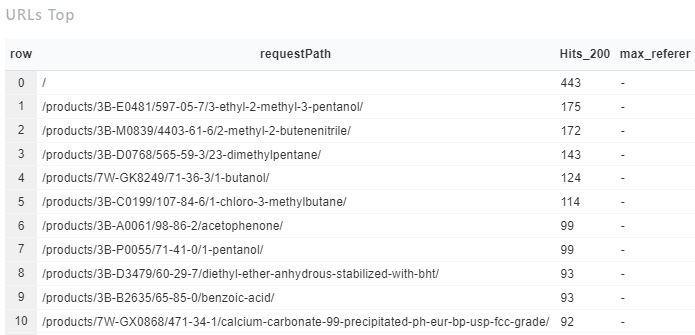

URL más rastreadas

Como ya hemos explicado en un punto anterior, cuanto más rastreada sea una URL, más relevante será por los buscadores. Las URL más rastreadas son, generalmente, las URL más enlazas internamente dentro de un site. Por tanto, si vemos que los logs rastrean mucho una URL que carece de importancia para nosotros, debemos revisar el enlazado interno para impedir que sea rastreada en tantas ocasiones y aplicar nofollow a sus enlaces y/o aplicar un disallow en el fichero robots.txt. Y, al contrario, si una URL que es muy importante, vemos que apenas es rastreada, debemos mejorar su enlazado interno para forzar al bot a que la rastree más.

Transferlogs, la herramienta desarrollada por Flat 101

Conociendo la importancia del análisis de logs para comprender el modo en que los buscadores rastrean los sites de nuestros clientes y para ayudarnos en la toma de decisiones para optimizar la captación de tráfico orgánico, el departamento de I+D desarrolló la herramienta Transferlogs.

Si bien es cierto que existen multitud de herramientas en el mercado que nos permiten analizar los logs como Screaming Frog SEO Log File Analyser o Loggly, decidimos tener nuestra propia tool, lo más versátil posible.

Esta herramienta, recibe los logs del servidor de nuestro cliente y los filtra, almacenando en base de datos únicamente los hits de bots de búsqueda reales. Esto nos facilita enormemente el trabajo a todos los SEO de Flat 101.

El hecho de tener los logs almacenados en base de datos, nos permite una gran adaptabilidad ya que podemos configurar dashboards a medida en los que mediante consultas SQL, podemos pintar los gráficos y tablas que nos ayuden en nuestro análisis y de esta forma plantear acciones que ayuden a mejorar el rastreo y el posicionamiento orgánico de nuestros clientes.